长期回收H5WRAGESM8W-N4L海力士-回收

- 面议

- 2024-12-16 11:52:20

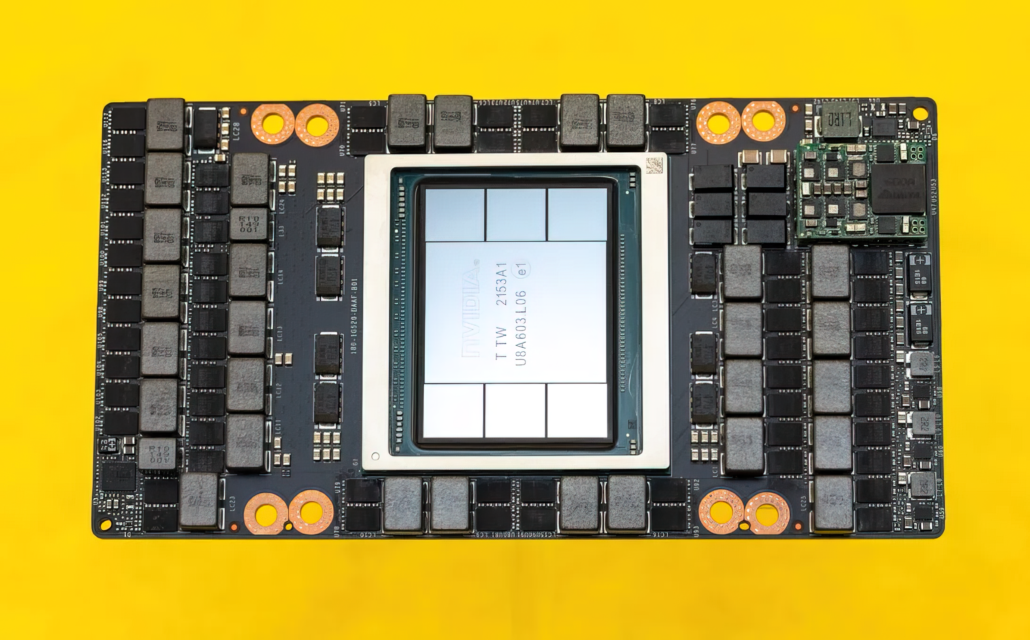

- 工厂库存,电子料,芯片,GPU显卡HBM

- 上海

- 谢生 13636336610

- 上海睿劳电子科技有限公司

信息介绍

详细参数

长期回收H5WRAGESM8W-N4L海力士-回收

人工智能(AI)技术的迅猛发展为各个领域带来了性的变化,而图形处理器(GPU)作为一种强大的计算硬件,在AI应用中扮演着至关重要的角色。

深度学习是人工智能的核心技术之一,它的训练过程需要大量的计算和数据处理。传统的处理器(CPU)在处理大规模的神经网络时效率较低,而GPU以其并行计算能力迅速崭露头角。GPU的并行架构允许同时处理多个任务,尤其适合深度学习中大量的矩阵运算。因此,许多深度学习框架如TensorFlow、PyTorch等都支持GPU加速,显著提高了训练速度。

计算

GPU在图形处理上的出色表现使其成为处理复杂计算的理想选择,特别是在处理大规模数据集时。在人工智能应用中,大量的数据需要被迅速处理和分析,例如自然语言处理、图像识别等领域。GPU的计算能力可以加快数据处理过程,从而加速模型训练和推理,为实时决策提供支持。

深度神经网络的加速

深度神经网络(DNNs)是现代人工智能应用中的核心,它们的训练和推理需要进行大量的计算。GPU的并行处理特性使其能够地处理DNNs中的矩阵运算和卷积操作,从而大大加快了模型的训练和推理速度。这对于需要快速响应的实时应用(如自动驾驶、语音识别等)尤为重要。

者友好性

GPU不仅在性能方面有优势,还在者友好性上具备吸引力。许多深度学习框架和库(如CUDA、cuDNN等)提供了与GPU紧密集成的工具,使者能够更轻松地利用GPU的计算能力。此外,许多云计算平台也提供了GPU实例,使者可以在云上快速构建和部署AI模型。

推动创新和研究

GPU的计算能力为研究人员和创新者提供了更大的灵活性和可能性。它们可以更快地训练更复杂的模型,探索更多的网络架构和算法,从而推动人工智能领域的创新发展。此外,GPU的并行计算能力还使得许多实验性的AI技术变得可行,如生成对抗网络(GANs)等。

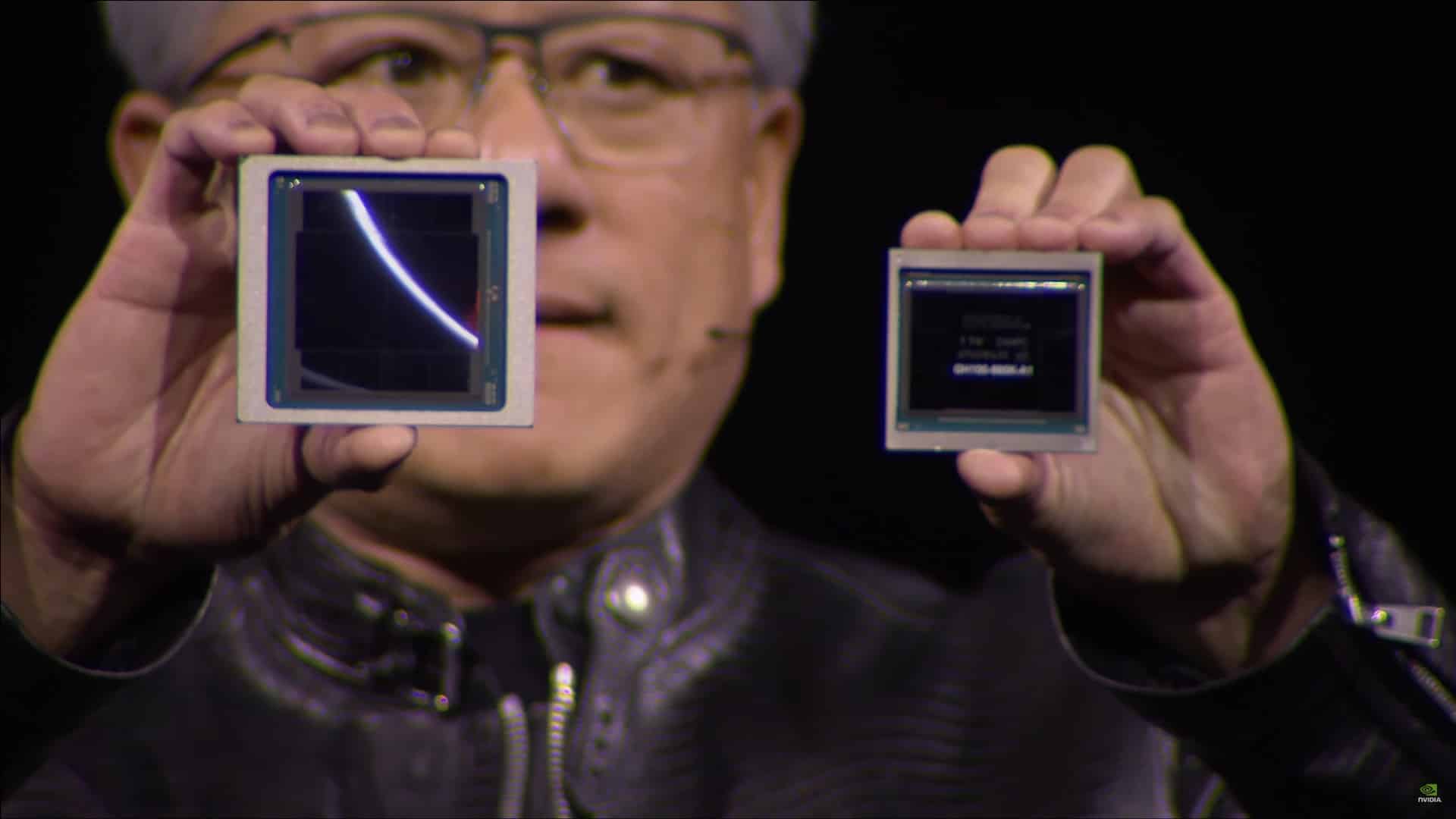

GA102-895-A1 GA102-875-A1 GA102-850-A1 GA104-875-A1 TU102-875-A1 AD102-30B-A1 AD102-87S-A1 AD102-895-A1 AD104-895-A1 AD103-301-A1 AD104-875-A1

GA100-893FF-A1 GA100-895GG1-A1 GA100-895FF-A1 GA100-875GG1-A1 GA100-874 AA-A1 GA100-884 AA-A1 GA100-882AA-A1 GH100-884K-A1 GH100-885F-A1 H800865K-A1

GA102-895-A1 GA10-87-A1 GA102-85-A1 GA104-875-A1 TU102-875-A1 AD102-30-A1 AD102-87-A1AD102-895-A1AD104-895-A1 AD103-301-A1 AD104-875-A1TU104-450-A1 TU106-410-A1

TU1040-A1 TU102-300A-K1-A1 TU102-30AKS-A1 T7U104-400A-A1 TU104-40O-A1 TU106-20A-KA-A1 TU106-400A-A1 TU106-400A-A1 GP102-3004-K1-A1 TU102-300A4K5-A TU116-4-A1 TU116-310-A1

GP106-350-K1-A1 GV102-400-A1 GP104-30-A1 GP104-2-A1 GP104-40-A1 GP106-400-A1 GP106-30-A1GP107-400-A1

- 工厂库存,电子料,芯片,GPU显卡HBM

- 记忆存储芯片

- 上海

- 谢生